2025年1月,微软计划将DeepSeek-R1模型的NPU优化版引入搭载高通骁龙X处理器的Microsoft Copilot PC。随后,微软发布了经过微调的DeepSeek-R1-Distill-Qwen-1.5B版本。如今,微软通过Microsoft Azure AI Foundry为这些AI PC带来了DeepSeek-R1 7B和14B精简版模型,使得这些设备能够通过本地NPU单元运行AI任务,无需依赖云端计算。

由于模型在本地NPU单元上运行,用户可以持续获得AI计算能力,既无需通过API调用付费,也能通过本地运行延长设备续航时间。同时,CPU和GPU可以腾出资源处理其他任务。微软使用内部自动量化工具Aqua将所有DeepSeek模型变体量化为int4权重,但目前的模型token速度较低。根据微软测试,14B版本的速度仅为8tok/秒,而1.5B版本可以达到40tok/秒。微软表示将继续优化模型以提高速度。

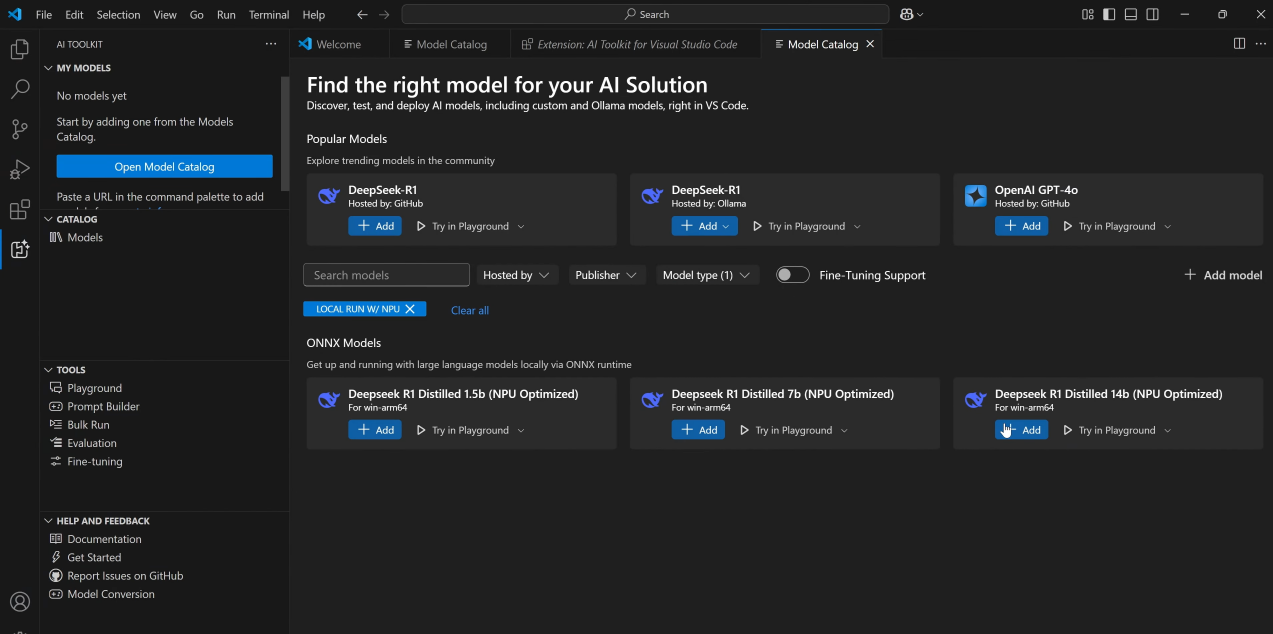

此外,开发者现在可以通过AI ToolKit VS Code扩展在Copilot+PC上下载并运行DeepSeek模型的1.5B、7B和14B版本。这些模型通过ONNX QDQ格式进行优化,也可以直接从Azure AI Foundry下载。未来,微软计划将这些优化模型推广到搭载英特尔和AMD处理器且具备NPU单元的笔记本电脑上,而不具备NPU单元的设备暂时无法使用此类AI功能。

版权声明:

本站刊登文章,除非文中已经注明来源网站,否则均为 OurDown.com 原创内容,转载时请务必以超链接(而非纯文本链接)标注来源于OurDown.com 及本文完整链接,原文链接:https://www.ourdown.com/archives/96.html,感谢阅读!

评论0